一个模型实现生成+编辑!通义万相 Wan2.1-VACE 正式开源

作者:通义万相Wan 更新时间:2025-06-23 15:29:17 共343人关注

今日,阿里巴巴正式开源通义万相「Wan2.1-VACE」,这是业界功能最全的视频生成与编辑模型,单一模型可同时支持文生视频、图像参考视频生成、视频重绘、视频局部编辑、视频背景延展以及视频时长延展等全系列基础生成和编辑能力。本次共开源1.3B和14B两个版本,其中1.3B版本可在消费级显卡运行,开发者可在GitHub、HuggingFace及魔搭社区下载体验。该模型还将逐步在通义万相官网和阿里云百炼上线。

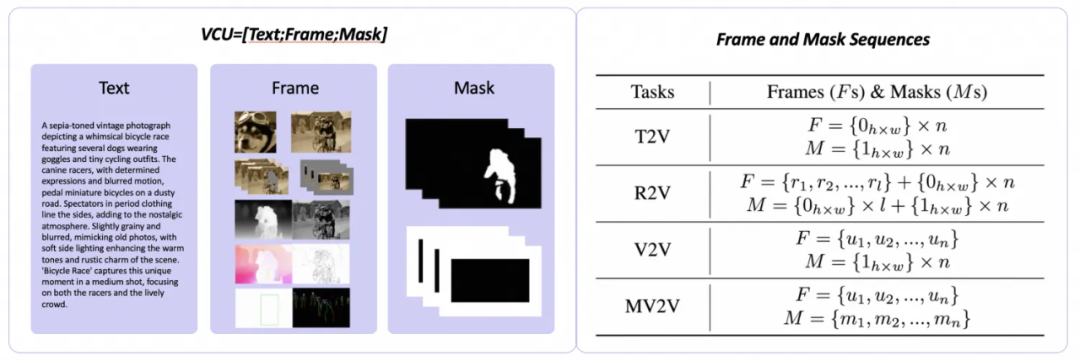

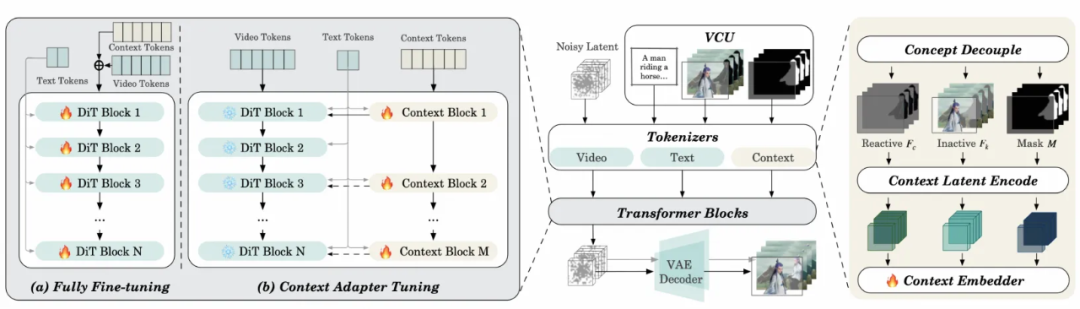

Wan2.1-VACE在通义万相文生视频模型基础上,创新性提出了全新的视频条件单元 VCU,它在输入形态上统一了文生视频、参考图生视频、视频生视频,基于局部区域的视频生视频4大类视频生成和编辑任务。

同时,Wan2.1-VACE还进一步解决了多模态输入的token序列化难题,将VCU输入的帧序列进行概念解耦,分开重构成可变序列和不可变序列后进行编码,有效提升训练效率和视频生成的质量。

另外,Wan2.1-VACE还支持任意基础能力的自由组合,用户无需针对特定功能训练一个新的专家模型,通过输入条件的组合即可完成更复杂的任务,极大地扩展了AI视频生成的想象空间。例如,将图片参考和主体重塑功能组合,可以实现视频的物体替换;将图片参考、首帧参考、背景扩展和时长延展功能,可以将一张竖版图片变成横版视频,并且在其中加入参考图片中的元素。

自今年2月以来,通义万相已先后开源文生视频模型、图生视频模型和首尾帧生视频模型,目前在开源社区的下载量已超330万,在GitHub上斩获超1.1w Star,是同期最受欢迎的视频生成模型。

开源地址:

开源地址:GitHub:https://github.com/Wan-Video/Wan2.1

HuggingFace:https://huggingface.co/Wan-AI

魔搭社区:https://www.modelscope.cn/organization/Wan-AI?tab=model