从闭源到开源,OpenAI重磅推出gpt-oss-120b与20b,开发者狂欢!

作者:AIbase基地 更新时间:2025-08-06 10:32:20 共275人关注

OpenAI宣布推出两款开源权重语言模型——gpt-oss-120b和gpt-oss-20b,这是自2019年GPT-2发布以来,OpenAI首次回归开源领域。此举不仅标志着OpenAI战略的重大转向,也为全球AI开发者提供了强大的推理工具,加速AI技术的普及与创新。

根据OpenAI官方公告,gpt-oss-120b和gpt-oss-20b采用Apache2.0许可证发布,允许开发者自由下载、修改和用于商业用途。这两款模型分别是1170亿参数和210亿参数的混合专家(MoE)架构,分别激活51亿和36亿参数,兼顾高效推理与低资源消耗。

这些模型支持长达128k token的上下文长度,采用交替密集和局部带状稀疏注意力机制,并使用分组多查询注意力技术以提升推理效率。OpenAI还开源了‘o200k_harmony’分词器,进一步降低开发门槛。

OpenAI在发布中强调,安全是gpt-oss系列的核心原则。针对开源模型可能被恶意微调的风险,OpenAI对gpt-oss-120b进行了对抗性微调测试,并通过其“准备框架”(Preparedness Framework)验证,确认即使经过恶意优化,模型在生物、化学及网络安全领域也未达到高风险能力水平。外部安全专家的审查进一步提升了模型的安全标准。

此外,OpenAI呼吁开发者在使用模型时,结合自身需求实施额外安全措施,以应对多样化应用场景中的潜在风险。模型卡和研究论文中详细披露了安全测试结果,为开源社区提供了透明参考。

OpenAI此举被认为是应对开源领域竞争的战略调整。近年来,Meta、DeepSeek等公司通过开放模型抢占市场,迫使OpenAI重新审视其闭源策略。OpenAI首席执行官Sam Altman在Reddit AMA中曾表示,公司过去的开源路线“走错了方向”,此次发布则是兑现其回归开源承诺的第一步。

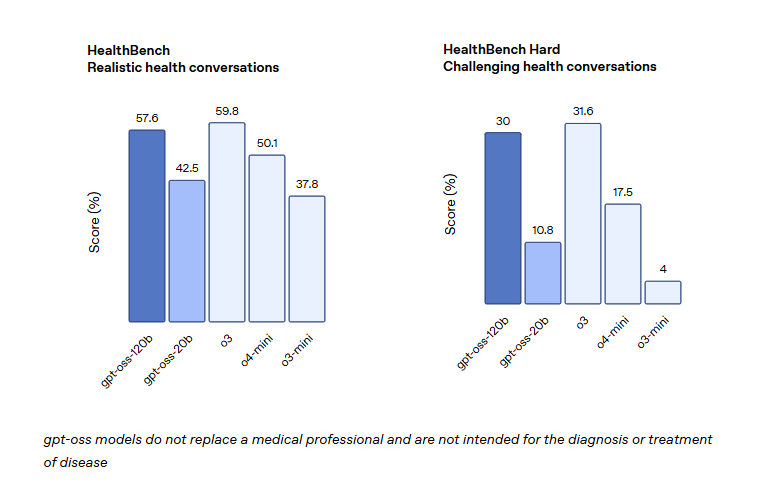

同时,gpt-oss系列满足了企业对本地化部署和数据隐私的需求。金融、医疗、法律等高监管行业可将模型部署在私有服务器上,避免数据泄露风险。OpenAI还与瑞典国家人工智能中心AI Sweden等机构合作,探索区域性微调以提升模型在特定语言和文化背景下的表现。

gpt-oss系列支持多种开发框架,如Transformers、vLLM、Ollama和llama.cpp,开发者可通过Hugging Face、GitHub等平台下载模型权重,并利用OpenAI提供的参考代码快速上手。模型内置链式推理(Chain-of-Thought)、工具调用(支持Python代码执行、网页搜索等)及结构化输出(JSON、YAML等),特别适合构建智能体工作流。

此外,模型支持三种推理等级(低、中、高),开发者可根据任务需求平衡速度与精度。

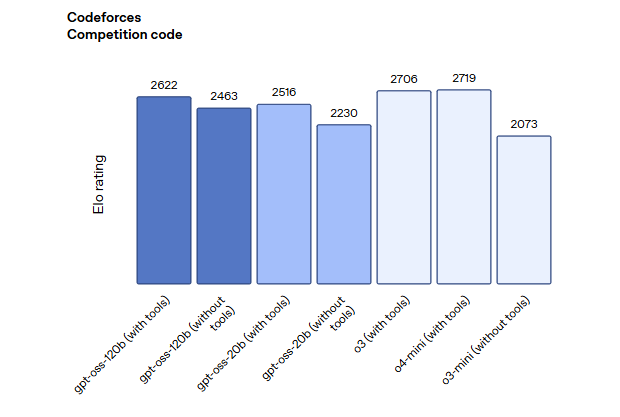

gpt-oss的发布不仅为开发者提供了高性能、低成本的AI工具,也对AI行业格局产生了深远影响。相较于Meta的Llama或DeepSeek的R1,gpt-oss在推理能力和工具使用上具有明显优势,但其文本单模态的限制也意味着需通过API调用补充多模态功能。

OpenAI表示,未来将根据社区反馈持续优化gpt-oss系列,但未承诺具体更新计划。业内专家认为,此举可能推动更多企业采用混合AI策略,即结合开源模型与云端服务,兼顾成本与灵活性。

官方博客:https://openai.com/zh-Hans-CN/index/introducing-gpt-oss/