谷歌 DeepMind 推出 MoR 架构:有望大幅提升大型语言模型的效率

作者:AIbase基地 更新时间:2025-07-17 18:42:26 共625人关注

在人工智能领域,大型语言模型(LLM)因其出色的表现而受到广泛关注,但其在部署时却面临着巨大的计算和内存开销问题。为了克服这一挑战,谷歌 DeepMind 最近推出了一种新架构 ——Mixture-of-Recursions(MoR),该架构被认为有潜力成为传统 Transformer 模型的 “杀手”。

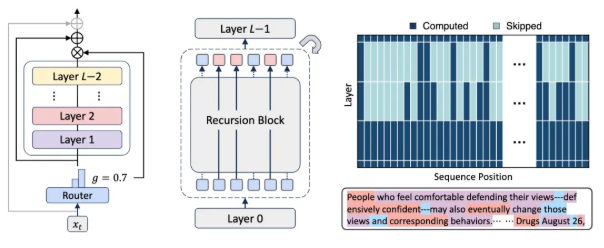

MoR 架构在递归 Transformer 的基础上进行了创新,旨在同时实现参数共享和自适应计算。通过将动态的 token 级路由集成到高效的递归 Transformer 中,MoR 能够在不增加模型成本的情况下,提供与大型模型相媲美的性能。该模型通过轻量级路由系统,为每个 token 分配专属的递归深度,动态决定每个 token 所需的 “思考” 层数。这种方法能够有效分配计算资源,提升处理效率。

在具体实现上,MoR 采用了一种先进的缓存机制,该机制能够根据 token 的递归深度选择性地缓存和检索相关的键值对。这一创新显著降低了内存带宽压力,提高了推理吞吐量。同时,MoR 还通过参数共享、计算路由和递归级缓存等多项优化措施,显著减少了参数量,降低了计算开销。

在实验中,MoR 在相同计算预算下以更少的参数数量超越了原始 Transformer 和递归 Transformer,验证了其优越的性能。通过与基线模型进行对比,MoR 在少样本学习的平均准确率上也取得了更好的成绩,尽管其参数量减少近50%。这一成功归因于其高效的计算策略,使得 MoR 能够处理更多的训练 token。

此外,研究人员还发现,MoR 在不同计算预算下始终优于递归基线模型,尤其在模型规模超过360M 时,MoR 不仅能够追平原始 Transformer,还能在低至中等预算下常常超越对手。因此,MoR 被视为一种可扩展且高效的替代方案,适合用于大规模的预训练和部署。

随着 AI 技术的不断发展,MoR 架构的推出为大型语言模型的高效化提供了新的解决方案,预示着 AI 研究领域的新突破。

论文链接:alphaxiv.org/abs/2507.10524

划重点:

🌟 MoR 架构通过动态分配计算资源和缓存机制,有效提高大型语言模型的效率。

📉 在相同计算预算下,MoR 以更少参数超越传统 Transformer,性能更优。

🚀 MoR 被视为 AI 研究中的新突破,适合大规模预训练与部署。