字节跳动开源新模型VINCIE-3B:3亿参数,支持上下文连续图像编辑

作者:AIbase基地 更新时间:2025-07-04 15:12:26 共291人关注

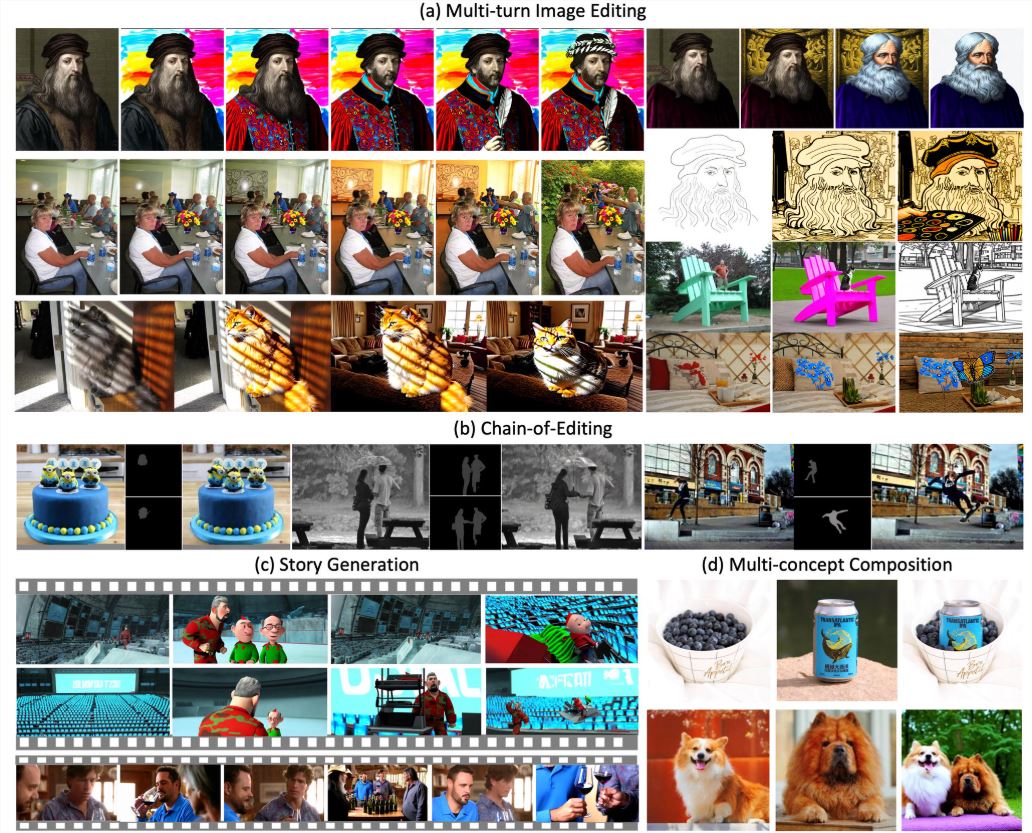

字节跳动宣布开源VINCIE-3B,一款支持上下文连续图像编辑的3亿参数模型,基于其内部MM-DiT架构开发。这款模型突破了传统图像编辑的局限,首次实现从单一视频数据中学习上下文感知的图像编辑能力,无需依赖复杂的分割或修复模型生成训练数据。VINCIE-3B的发布为创意设计、影视后期及内容生成领域带来了全新的可能性。AIbase深入剖析其技术亮点、应用场景及行业影响。

传统图像编辑模型通常依赖任务特定的数据管道,需通过专家模型(如分割、修复)生成训练数据,成本高且流程复杂。VINCIE-3B创新性地直接从视频中学习,通过将视频转化为交错多模态序列(文本+图像),实现上下文感知的图像编辑。具体技术亮点包括:

在性能测试中,VINCIE-3B在KontextBench和新型多轮图像编辑基准测试中达到业界领先水平(SOTA),尤其在文本遵循性、角色一致性和复杂场景编辑(如动态物体移动)上表现优异。生成一张高质量编辑图像的平均时间约为4秒,推理效率比同类模型快约8倍。

VINCIE-3B的完整代码、模型权重及训练数据处理流程已于2025年6月14日在GitHub和arXiv上发布,开发者可通过申请获取完整数据集(联系邮箱:yangsiqian@bilibili.com)。模型基于字节跳动的MM-DiT(3B和7B参数版本)初始化,采用Apache2.0许可证,支持非商业用途,商业应用需联系字节跳动获取许可。

字节跳动还推出了一个多轮图像编辑基准测试,包含真实场景用例,鼓励社区验证和优化模型性能。社交媒体上,开发者对VINCIE-3B的开源表示热烈欢迎,认为其“从视频学习”的方法为低成本AI内容创作开辟了新路径。

VINCIE-3B支持基于文本和先前图像的连续编辑,适用于多种场景:

例如,提示“将穿红裙的女孩从公园移到海滩,保持裙子纹理,调整为夕阳光照”可生成自然融合的图像,裙子细节和光影效果高度逼真。AIbase测试显示,VINCIE-3B在多轮编辑中能保持90%以上的角色一致性,优于FLUX.1Kontext [pro]在复杂场景下的表现。

尽管VINCIE-3B表现出色,仍有一些局限:

AIbase建议用户在使用VINCIE-3B时,结合其提供的KontextBench数据集进行测试,以优化提示设计。对于商业用户,建议联系字节跳动明确许可条款。

VINCIE-3B的发布标志着图像编辑从静态到动态、从单一到上下文连续的范式转变。与Black Forest Labs的FLUX.1Kontext(专注于静态图像编辑)相比,VINCIE-3B通过视频学习实现了更强的动态场景理解,特别适合需要时间序列一致性的应用。 相比Bilibili的AniSora V3(专注于动漫视频生成),VINCIE-3B更通用,覆盖现实场景和虚拟内容生成。

字节跳动的开源策略进一步巩固了其在AI创意工具领域的领先地位。AIbase认为,VINCIE-3B的“视频到图像”训练方法可能启发其他公司探索类似路径,降低AI模型开发成本,推动创意产业的民主化。

huggingface:https://huggingface.co/ByteDance-Seed/VINCIE-3B